2025-04-19 10:30

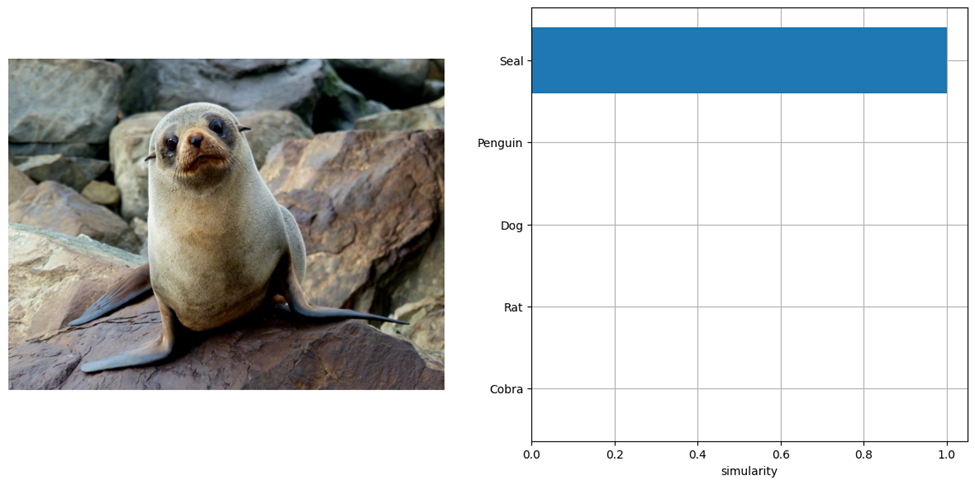

我们很高兴宣布最新版本的OpenVino™2025的正式发布!此更新带来了工程团队的更多增强和新功能。每次发布时,我们都会继续适应AI发展的不断变化的速度,并面临无尽的新机会和复杂的挑战。在此版本中,我们专注于增强新模型的范围和对实际应用程序情况的支持,并深入抛光性能优化,以帮助您的AI解决方案更快,更好地运行。本文指出:版本2025.1中的新模型和应用程序方案,我们添加了对以下模型的支持:PHI-4 MINI,JINA CLIP V1和BCE嵌入基础V1。其中,PHI-4 Mini来自最新的Microsoft Source Small Model Ofphi系列。您可以使用GitHub尝试此模型,并使用它来生产LLM聊天机器人或探索许多其他LLM型号。我们也很高兴表达对Jina Clip V1的支持,Jina Clip V1是一种与T有关的多模式AI模型ext images and data, and is widely used in scenarios such as visual search, multimodal Q&A and content generation.我们向Github提供了新的互动示例,以供开发人员启动。下图显示了模型的输出效果:图1:使用Jina Clip和OpenVino™模型剪辑。图像到图像转换和维修。在此更新中,这两个功能得到了充分的支持,而canyou将快速为图像生成模型(例如Flux.1和OpenVino™稳定扩散V3)部署端到端流程。如今,OpenVino™模型服务器(OVM)支持视觉语言模型(VLMS),例如qwen2-vl,phi-3.5-Vision和internvl2。它使您可以将推理图像发送到对话场景,例如与LLM打交道。我们提供了持续批处理下VLM扩展示范的实例。此外,您现在可以使用OVM将LLM和VLM型号部署到NPU加速器上,以实现AI PCMAGS的高效率和低成本 - 应用程序。我们提供一家公司mplete sample code for deploying LLM to the NPU on the docker and bare metal environments and VLM at the NPU. 。 。 。与以前的2025.0版相比,GPU AY吞吐量的第二个令牌在2025.1版本中增加了1.4倍。基准的具体结果如下图所示。图3:OpenVino™2025.1使用Intel®Core™Ultra 200H系列处理器改善LLM性能,请参阅加载和调整附录。结果可能会根据场景而有所不同。此更新的一个重要亮点是对令牌令牌机制(令牌清除)的预览支持,用于加强KV高速缓存大小的管理。该机制可以自动维护必不可少的令牌和 - 透明的不必要信息,从而大大降低了内存的使用,同时确保模型性能。这特别适用于持有长输入的LLM和VLM应用程序。清除令牌后,KV缓存将自动“调整”以维护U上下文。执行官是Pytorch Modelo的执行官,可以在侧面设备上很好地操作模型,适用于强制资源和内存的场景。借助OpenVino™的新版本,我们引入了OpenVino™对Executorch的OpenVino™的支持,以加快理解并提高Intel CPU,GPU和NPU中实现模型的效率。要开始使用OpenVino™Backend以运行高管,请参阅GitHub文档。 。这里提供了Intel CPU,集成GPU,NPU和其他加速器的模型性能数据,以帮助您找到解决方案的最佳硬件平台。图4:由于您的关注和参与最新的OpenVino™版本,OpenVino™模型中心显示了基准基准的性能摘要。我们总是专注于各地的枕头。附录

我们很高兴宣布最新版本的OpenVino™2025的正式发布!此更新带来了工程团队的更多增强和新功能。每次发布时,我们都会继续适应AI发展的不断变化的速度,并面临无尽的新机会和复杂的挑战。在此版本中,我们专注于增强新模型的范围和对实际应用程序情况的支持,并深入抛光性能优化,以帮助您的AI解决方案更快,更好地运行。本文指出:版本2025.1中的新模型和应用程序方案,我们添加了对以下模型的支持:PHI-4 MINI,JINA CLIP V1和BCE嵌入基础V1。其中,PHI-4 Mini来自最新的Microsoft Source Small Model Ofphi系列。您可以使用GitHub尝试此模型,并使用它来生产LLM聊天机器人或探索许多其他LLM型号。我们也很高兴表达对Jina Clip V1的支持,Jina Clip V1是一种与T有关的多模式AI模型ext images and data, and is widely used in scenarios such as visual search, multimodal Q&A and content generation.我们向Github提供了新的互动示例,以供开发人员启动。下图显示了模型的输出效果:图1:使用Jina Clip和OpenVino™模型剪辑。图像到图像转换和维修。在此更新中,这两个功能得到了充分的支持,而canyou将快速为图像生成模型(例如Flux.1和OpenVino™稳定扩散V3)部署端到端流程。如今,OpenVino™模型服务器(OVM)支持视觉语言模型(VLMS),例如qwen2-vl,phi-3.5-Vision和internvl2。它使您可以将推理图像发送到对话场景,例如与LLM打交道。我们提供了持续批处理下VLM扩展示范的实例。此外,您现在可以使用OVM将LLM和VLM型号部署到NPU加速器上,以实现AI PCMAGS的高效率和低成本 - 应用程序。我们提供一家公司mplete sample code for deploying LLM to the NPU on the docker and bare metal environments and VLM at the NPU. 。 。 。与以前的2025.0版相比,GPU AY吞吐量的第二个令牌在2025.1版本中增加了1.4倍。基准的具体结果如下图所示。图3:OpenVino™2025.1使用Intel®Core™Ultra 200H系列处理器改善LLM性能,请参阅加载和调整附录。结果可能会根据场景而有所不同。此更新的一个重要亮点是对令牌令牌机制(令牌清除)的预览支持,用于加强KV高速缓存大小的管理。该机制可以自动维护必不可少的令牌和 - 透明的不必要信息,从而大大降低了内存的使用,同时确保模型性能。这特别适用于持有长输入的LLM和VLM应用程序。清除令牌后,KV缓存将自动“调整”以维护U上下文。执行官是Pytorch Modelo的执行官,可以在侧面设备上很好地操作模型,适用于强制资源和内存的场景。借助OpenVino™的新版本,我们引入了OpenVino™对Executorch的OpenVino™的支持,以加快理解并提高Intel CPU,GPU和NPU中实现模型的效率。要开始使用OpenVino™Backend以运行高管,请参阅GitHub文档。 。这里提供了Intel CPU,集成GPU,NPU和其他加速器的模型性能数据,以帮助您找到解决方案的最佳硬件平台。图4:由于您的关注和参与最新的OpenVino™版本,OpenVino™模型中心显示了基准基准的性能摘要。我们总是专注于各地的枕头。附录